训练方法

预训练(3阶段)

- 通用阶段:30万亿tokens,建立基础知识

- 推理阶段:5万亿高质量tokens,增强STEM和编程能力

- 长上下文阶段:扩展上下文长度至32K tokens

后训练(4阶段流程)

- 长CoT冷启动:建立基础推理模式

- 推理强化学习:优化数学和编程推理

- 思维模式融合:整合两种模式

- 通用强化学习:提升综合能力

Qwen团队在X post中解释停止使用混合思维模式的原始帖子地址是:https://x.com/Alibaba_Qwen/status/1947344511988076547

上nature了: https://www.nature.com/articles/s41586-025-09422-z

我之前的一个文章介绍: https://www.dong-blog.fun/post/2014

DeepSeek-R1的完整训练流程

1. DeepSeek-R1-Zero(纯强化学习路线)

DeepSeek-R1-Zero 也是一个重要成果,纯强化学习路线也是可以走的。

基础:直接基于DeepSeek-V3 Base模型 核心特点:

- 完全跳过SFT阶段 - 这是关键差异

- 仅使用GRPO进行大规模强化学习

- 只用规则基础奖励(准确率+格式奖励)

- 训练10,400步,历时1.6个训练周期

结果:

- 在AIME数学竞赛上从15.6%提升到77.9%

- 自然涌现Long-CoT能力(长链思维推理)

- 出现"aha moment"现象(突然大量使用"wait"等反思词汇)

- 但存在可读性差、语言混杂等问题

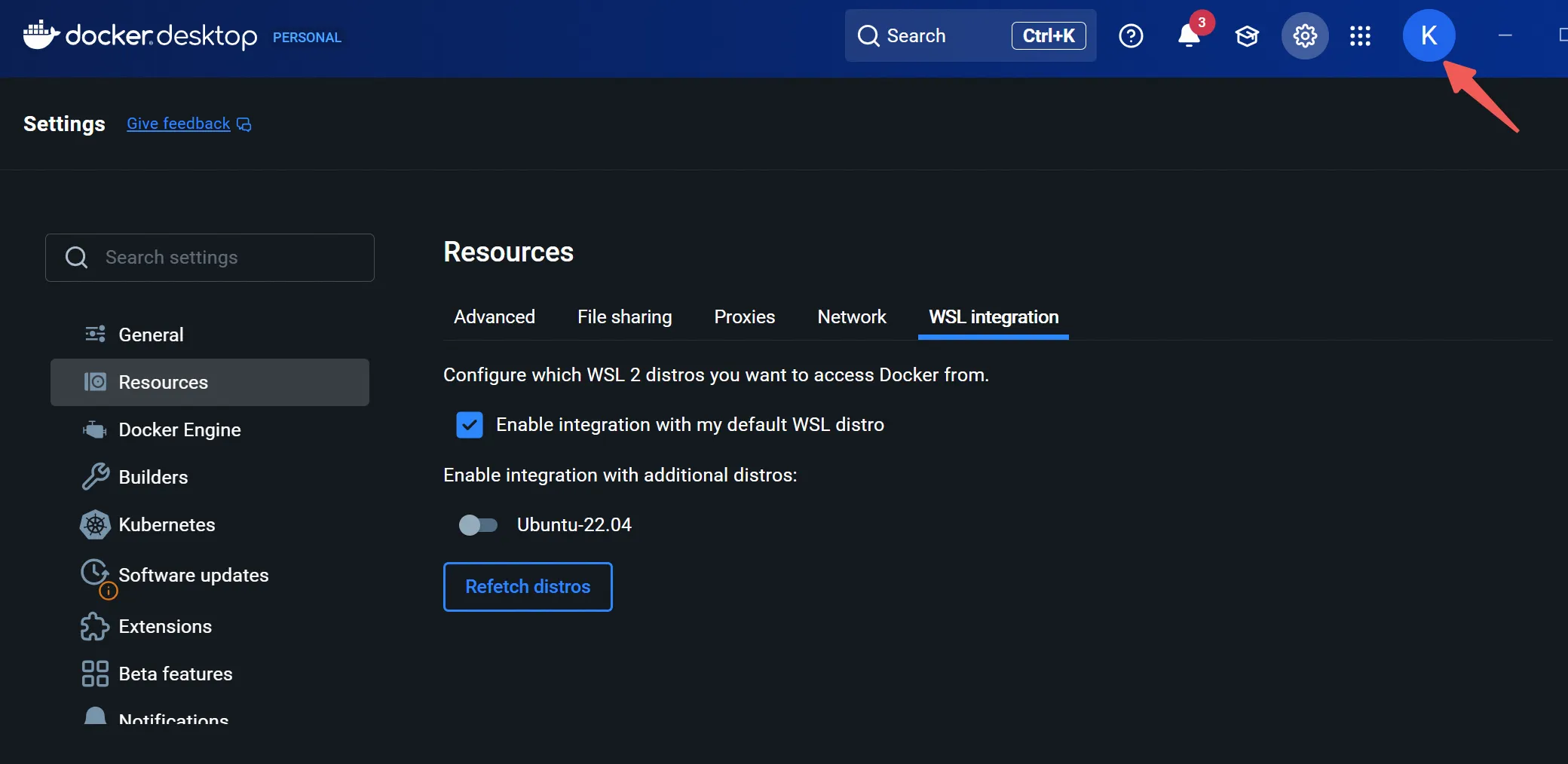

这问题困扰我很久,在评论管理页面无法看到管理。

最终才发现我登录Waline不是管理员身份导致的。需要修改数据库的表是最佳最快的解决办法。

bash展开代码docker ps # 查看mongo数据库的容器ID

# 进入 MongoDB 容器

docker exec -it <mongo容器ID> mongosh

# 切换到 waline 数据库

use waline

# 查看有哪些集合

waline> show collections

Comment

Users

https://mp.weixin.qq.com/s/3t4PjpZcMVU1wCO0ThUs2A

本文系统阐述了AI Agent开发中新兴的“上下文工程”(Context Engineering)概念及其核心方法论。随着Agent在实际运行中产生海量工具调用和长程推理(long horizon reasoning),管理冗长上下文成为影响性能、成本和模型能力的关键瓶颈。

核心挑战:

- Agent典型任务需约50次甚至上百次工具调用,导致上下文急速膨胀。

- 过长上下文不仅可能超出模型上下文窗口限制,更会导致“上下文衰减”(Context Decay),即模型注意力分散、推理能力下降。

五大核心策略:

- 转移(Offload):将工具调用产生的大量上下文(如网页内容、文档)转移到外部存储(如文件系统),仅在模型中保留摘要或标识符,需时再调用。关键在于生成高质量的摘要以避免信息丢失。

- 压缩(Reduce):通过总结(Summarization)或剪裁(Pruning)减少上下文内容。需谨慎操作,最好与Offload结合以确保原始信息可回溯,避免不可逆的信息损失。

- 检索(Retrieve):从外部知识库、记忆或文档中动态检索相关信息注入上下文。研究表明,简单的生成式检索(如提供文件列表让Agent自行选择调用)常比复杂的多步RAG流程更有效且成本更低。记忆管理可视为一种特定的检索场景。

- 隔离(Isolate):将上下文拆分给多个Agent(Multi-Agent)处理,避免单一Agent过载。此法适用于易并行、只读的任务(如深度研究),但在需要高度协同决策的场景(如编码)中可能引发冲突,需谨慎使用。

- 缓存(Cache):利用键值缓存(KV Cache)复用计算过的前缀token,可大幅降低延迟和成本(如Claude Sonnet缓存成本可降10倍)。但缓存仅优化计算效率,无法解决长上下文本身的模型衰减问题。

核心启示与未来方向: 文章引用Hyung Won Chung的“The Bitter Lesson”指出,AI进步的根本驱动力是计算规模(Scaling Law)而非人工设计的复杂结构(归纳偏置)。随着模型能力持续指数级提升(如Claude 3.5的发布),最佳策略是构建灵活、通用、少结构化的系统,而非嵌入过多当前有效的假设,以便更好地适应未来模型的能力。企业应用应倾向于采用透明、可组合的底层编排框架(如Shopify Roast),而非黑箱化的Agent抽象,从而在模型能力追上时释放最大价值。AI Native产品(如Cursor、Windsurf)从零构建的优势正于此显现。

https://arxiv.org/pdf/2509.14786

这篇论文《无限算力下的预训练》(Pre-training under infinite compute)由斯坦福大学的研究者撰写,核心探讨了在高质量训练数据有限但计算资源无限的未来场景下,如何通过算法改进来极大提升语言模型预训练的数据效率。以下是全文的核心总结:

1. 问题背景

- 算力增长(每年约4倍)远快于高质量网络文本数据的增长(每年约1.03倍)。

- 传统方法在数据受限时(如固定200M tokens),单纯增加训练轮次(epoch)或模型参数(parameters)会导致过拟合,性能下降。

2. 核心方法 & 发现

a) 正则化(Regularization)是关键

- 发现权重衰减(Weight Decay) 的最佳值比常规实践(如0.1)大30倍,能有效防止过拟合。

- 优化后的正则化方法使损失随参数增加遵循幂律下降,可外推其渐近线(asymptote)以估计无限算力下的最佳性能。

b) 集成学习(Ensembling)优于单一模型

- 训练多个独立模型并集成(平均输出),比单一大型模型达到更低的损失渐近线。

- 集成模型能更好地学习数据中的多种特征(“多视图”结构),避免单一模型的偏差。

c) 联合扩展配方(Joint Scaling Recipe)

- 结合轮次调整、正则化、参数扩展和集成扩展,在200M tokens上达到最佳渐近线。

- 相比基线方法,数据效率提升5.17倍(即用更少数据达到相同效果)。

d) 知识蒸馏(Distillation)压缩模型

- 将集成模型蒸馏为单个小模型(如参数量减少8倍),仍保留83%的集成收益。

- 自蒸馏(Self-Distillation):用同一架构的教师模型训练学生模型,性能反而提升,无需增加参数量。

检查是否联网,没有联网就自动重连wifi Guest。

bash展开代码mkdir/root/autowifi/ && vim /root/autowifi/wifi-watchdog.sh

写入:

bash展开代码#!/bin/bash

interface="wlan0" # 请根据你的实际接口名修改,如 wlp3s0

while true; do

if ! ping -c 1 www.baidu.com &> /dev/null; then

echo "WiFi disconnected. Attempting to reconnect..."

sudo systemctl restart NetworkManager

sleep 5

sudo nmcli device wifi connect "Guest" password "Guest"

fi

sleep 300 # 每300秒检查一次网络状态

done

设置屏幕dpi

bash展开代码adb shell wm density 270

强制杀死某个包:

bash展开代码adb shell am force-stop com.xx.xx

我在win的cmd里一打python3,就跳转到windows的应用商店了,我安装了miniconda3,也指定path了,为啥不用我的miniconda3呢?

这个问题很常见,主要是因为Windows 10/11有一个默认的Python应用别名会拦截python3命令。即使你安装了miniconda3并设置了PATH,Windows的应用执行别名优先级更高。