匈牙利算法是做什么的?通俗解释

匈牙利算法(Hungarian Algorithm)是一种用来解决**"最佳分配问题"的数学方法。它的核心任务是:"如何用最低成本,把N个任务分配给N个人,让总成本最小?"**(或者反过来,让收益最大)。

的问题:

1. OpenPose的输入和输出形状

输入形状:

cpp展开代码// 从 src/openpose/net/netCaffe.cpp:218 可以看到

if (inputData.getNumberDimensions() != 4 || inputData.getSize(1) != 3)

error("The Array inputData must have 4 dimensions: [batch size, 3 (RGB), height, width].");

输入张量形状: [batch_size, 3, height, width]

batch_size: 批次大小,通常为13: RGB三通道height, width: 图像的高度和宽度

CDP:共识驱动传播人脸聚类方法

摘要

CDP(Consensus-Driven Propagation)是一种高效的大规模无标签人脸聚类方法。该方法通过投票机制和图传播算法,实现对人脸特征的快速准确聚类。CDP具有线性时间复杂度,能够处理大规模数据集,并在保持高精度的同时提供出色的聚类性能。

1. 人脸检测方法数量和类型

InsightFace主要包含3种核心人脸检测方法:

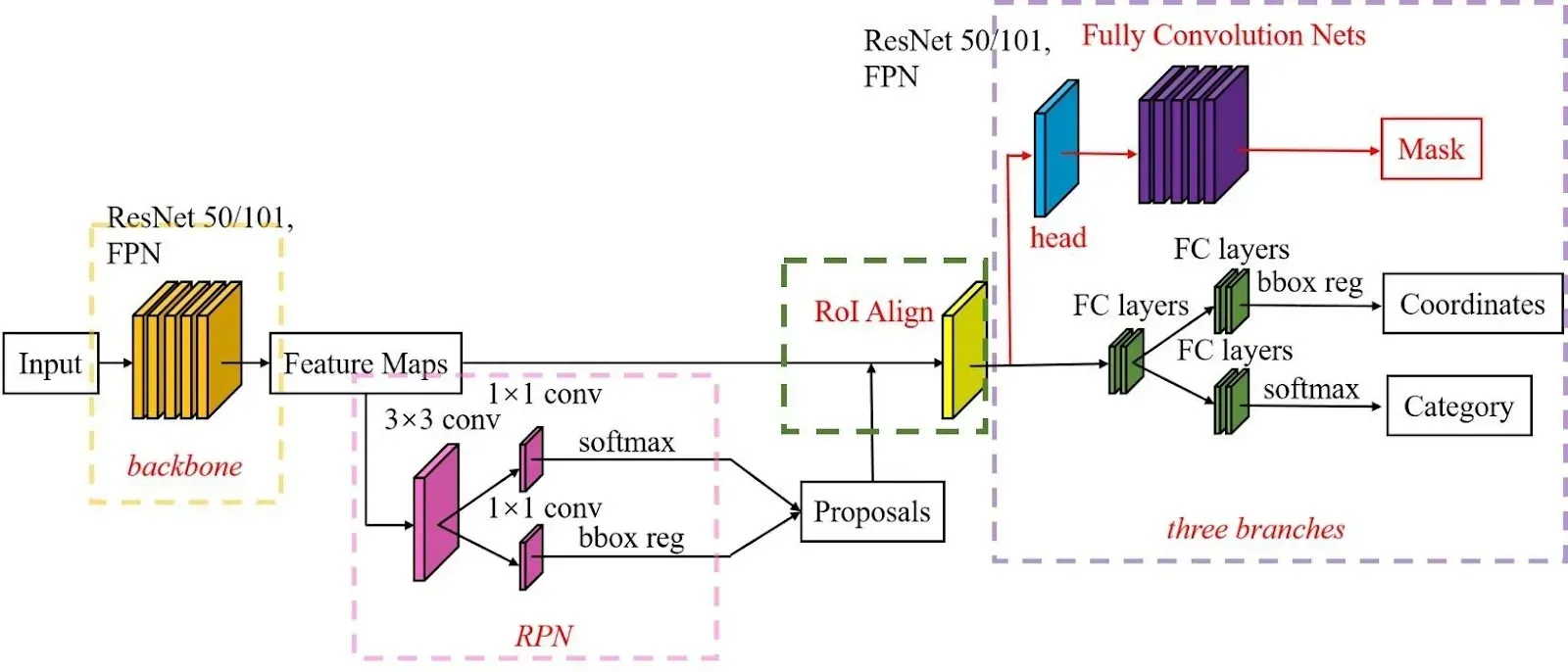

1.1 RetinaFace (CVPR 2020)

- 架构: 基于FPN的单阶段检测器

- 特点: 同时预测人脸边界框和5个关键点

- 骨干网络: ResNet50/ResNet152/MobileNet0.25

- 性能: WiderFace验证集 Easy 96.5, Medium 95.6, Hard 90.4

U-Net 2015 :编码器-解码器结构、跳跃连接。

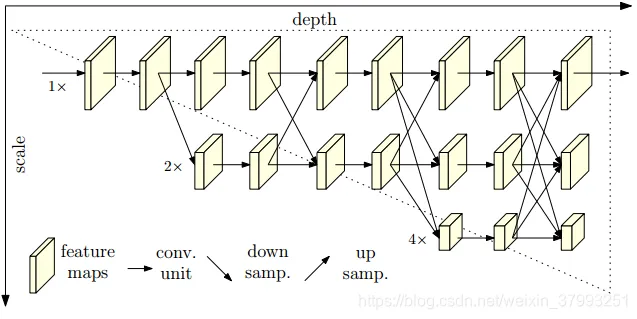

HRNet 2019 : 设计用于需要高分辨率特征的任务.

- 高分辨率主干( 网络从头到尾都维持一个高分辨率的特征流,而不是像U-Net那样先降维再升维。)

- 多尺度特征融合:

- 不同分辨率的特征流之间通过上采样和下采样操作进行交互,实现信息的跨尺度传递。

介绍

这是一个大模型机器人的试验尝试。效果预期就是可以将大模型引入QQ对话。

效果就是:让自己的QQ成为一个机器人客服,别人发消息给自己的QQ,自己的QQ自动就回复别人了,回复依靠的是大模型的语言能力。

项目在这里:https://astrbot.app/deploy/astrbot/docker.html#%E4%BD%BF%E7%94%A8-docker-%E9%83%A8%E7%BD%B2-astrbot

AstrBot 结合 NapCat 做QQ机器人, AstrBot 也可以结合其他消息中间件,做别的平台的机器人,比如微信、QQ、飞书、钉钉。

下载模型:

sh展开代码modelscope download Qwen/Qwen3-32B --local_dir ./Qwen/Qwen3-32B

部署:

bash展开代码# 拉取最新的

docker pull lmsysorg/sglang:v0.4.6.post1-cu121

# 启动服务

docker run -d --gpus '"device=0,1,2,3"' --shm-size=32g \

-v ./Qwen/Qwen3-32B:/model \

-p 8055:8000 \

-e PYTORCH_CUDA_ALLOC_CONF=expandable_segments:True \

lmsysorg/sglang:v0.4.6.post1-cu121 python3 -m sglang.launch_server --model-path /model --host 0.0.0.0 --port 8000 --mem-fraction-static 0.9 --tensor-parallel-size 4 --context-length 40960 --served-model-name "gpt" --api-key "abc"