如何构建自己的vllm镜像,cuda12.1

为了让镜像在cuda12.1.0编译,只能自己build一个镜像了。官方的现在的cuda12.4镜像。如果自己显卡的驱动不高,是无法支持cuda12.4的。

拉代码:

bash展开代码git clone --branch v0.6.3 --depth 1 https://github.com/vllm-project/vllm.git

cd vllm

Dockerfile开头改为这样,Dockerfile后面内容里的的12.4.1全部改为12.1.0

bash展开代码

ARG CUDA_VERSION=12.1.0

#################### BASE BUILD IMAGE ####################

# prepare basic build environment

FROM nvidia/cuda:${CUDA_VERSION}-devel-ubuntu20.04 AS base

ARG CUDA_VERSION=12.1.0

ARG PYTHON_VERSION=3.12

ENV DEBIAN_FRONTEND=noninteractive

打开魔法,然后进行build:

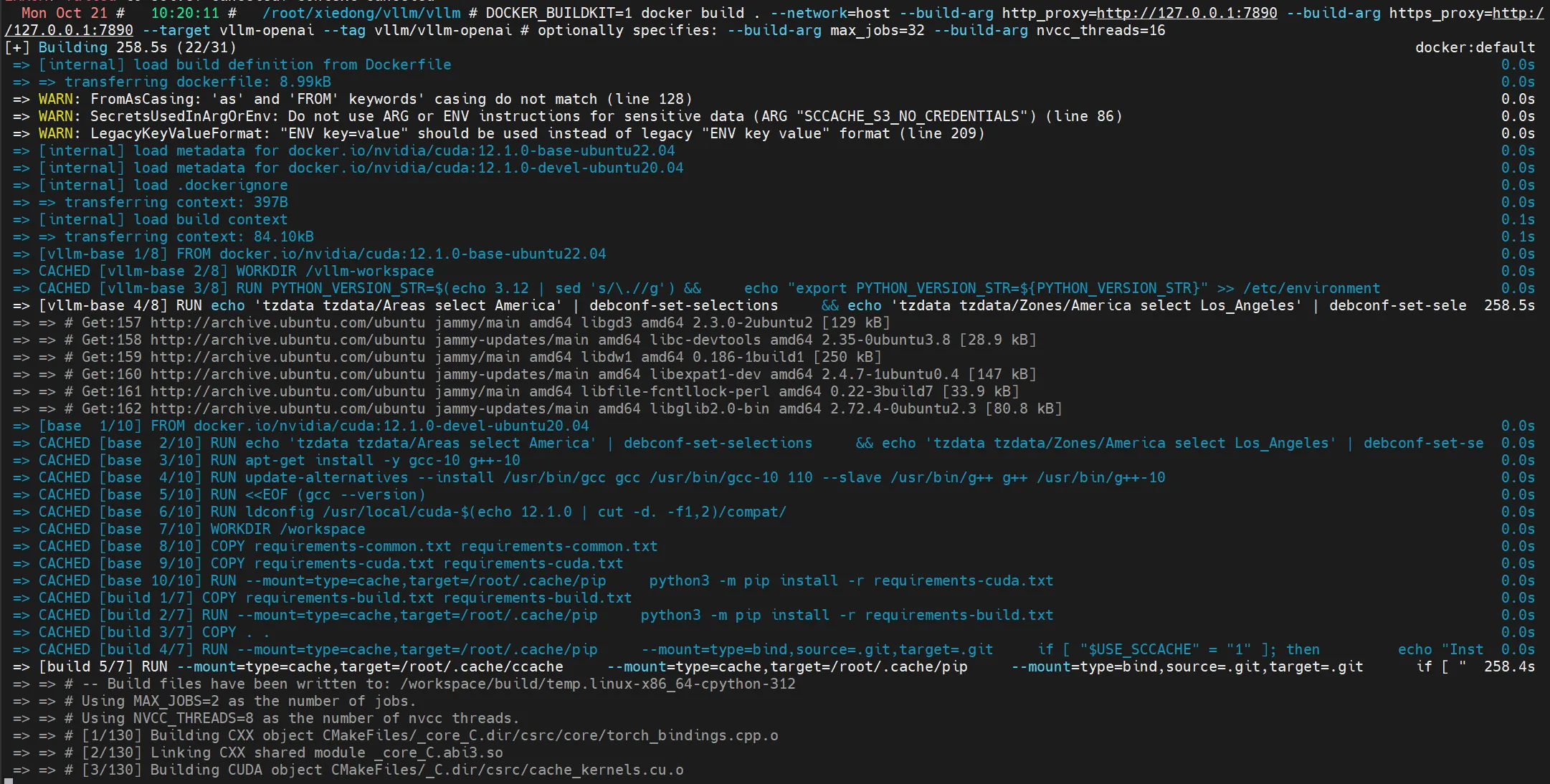

bash展开代码DOCKER_BUILDKIT=1 docker build . --network=host --build-arg http_proxy=http://127.0.0.1:7890 --build-arg https_proxy=http://127.0.0.1:7890 --target vllm-openai --tag vllm/vllm-openai # optionally specifies: --build-arg max_jobs=32 --build-arg nvcc_threads=16

docker魔法的一些方法

https://www.dong-blog.fun/post/1657

编译过程很慢,耐心等待:

如果对你有用的话,可以打赏哦

打赏

本文作者:Dong

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 CC BY-NC。本作品采用《知识共享署名-非商业性使用 4.0 国际许可协议》进行许可。您可以在非商业用途下自由转载和修改,但必须注明出处并提供原作者链接。 许可协议。转载请注明出处!