论文 AgentCPM-GUI

https://github.com/OpenBMB/AgentCPM-GUI/blob/main/README_zh.md

AgentCPM-GUI是由清华大学THUNLP实验室、中国人民大学与面壁智能团队联合开发的开源端侧智能体大模型,基于MiniCPM-V构建,总参数量8B,接受手机屏幕图像作为输入,自动执行用户提出的任务。AgentCPM-GUI的主要特性包括:

- 高质量GUI Grounding:通过在大规模中英文Android数据集上进行预训练,有效提升了对常见GUI控件(如按钮、输入框、标签、图标等)的定位与理解能力;

- 中文APP操作能力:首个针对中文APP精细优化的开源GUI Agent,覆盖高德地图、大众点评、哔哩哔哩、小红书等30余个主流中文APP;

- 增强的规划推理能力:通过强化微调技术(RFT),让模型输出动作前进行推理思考,有效提升复杂任务执行的成功率;

- 紧凑的动作空间设计:采用优化的动作空间和紧凑的JSON格式,平均动作长度压缩至9.7个token,提升端侧推理的效率。

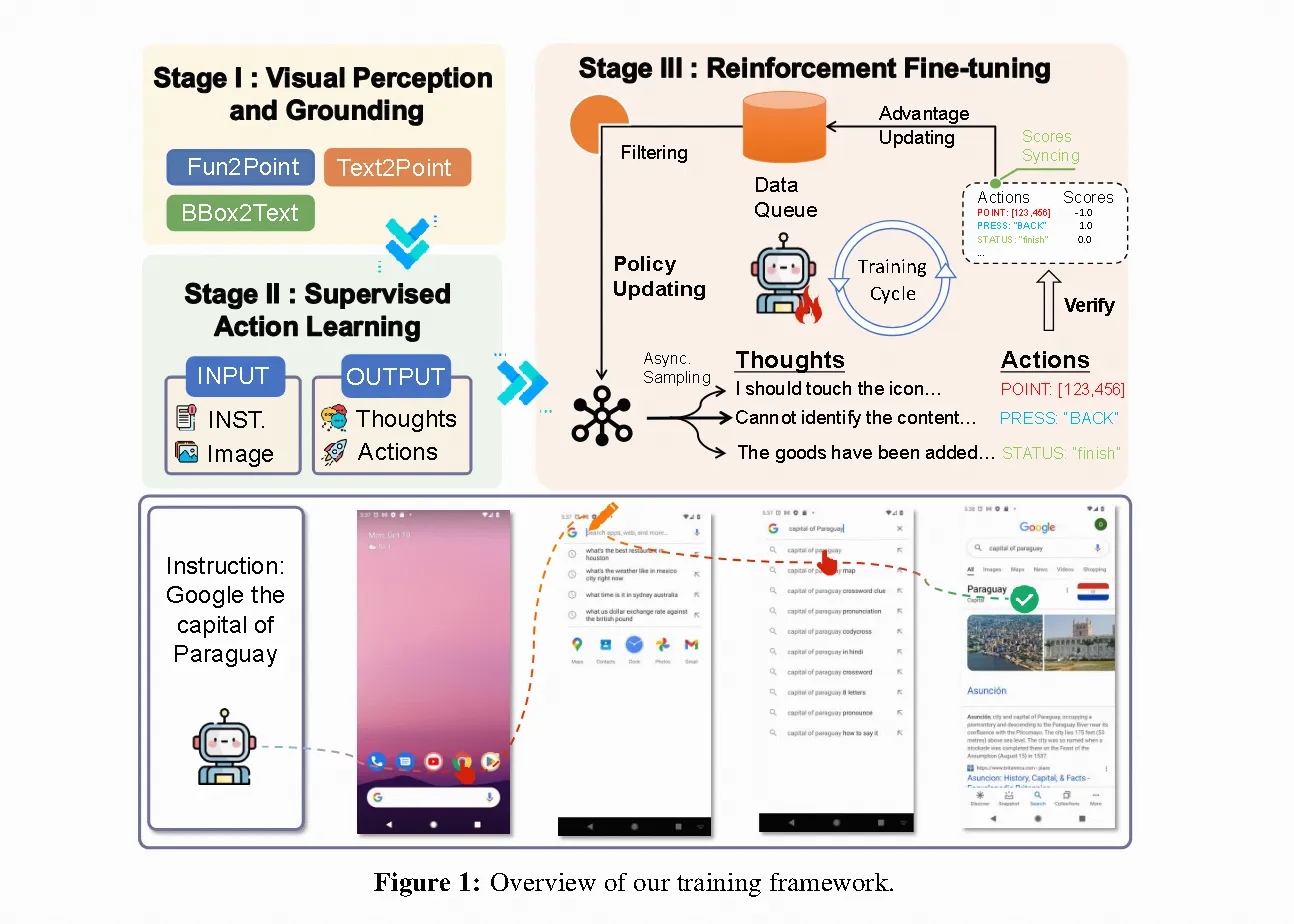

第一阶段:视觉感知与定位 该阶段重点强化模型的感知与定位能力。我们构建了包含OCR文字识别和控件定位任务的视觉-语言对齐数据集,使模型能精确建立GUI控件与其语义描述间的细粒度空间对应关系,为后续阶段奠定感知基础。

第二阶段:监督式模仿学习 基于第一阶段训练的模型,我们收集带自然语言标注的GUI任务执行轨迹数据进行监督微调。通过教导模型生成符合上下文的有效操作,使其能够根据查询指令模仿人类行为序列,实现从感知到行动的跨越。

第三阶段:强化微调 最终阶段采用强化微调(RFT)提升模型在复杂GUI环境中的推理决策能力。以收集的行为轨迹为初始示范,运用群体相对策略优化(GRPO,Shao等人2024)进行训练。该方法通过奖励正确且目标导向的行为序列,推动模型突破简单模仿,形成更强大的自主规划与自适应能力。

如果对你有用的话,可以打赏哦

打赏

本文作者:Dong

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 CC BY-NC。本作品采用《知识共享署名-非商业性使用 4.0 国际许可协议》进行许可。您可以在非商业用途下自由转载和修改,但必须注明出处并提供原作者链接。 许可协议。转载请注明出处!