Azure OpenAI 转 openai proxy接口

目录

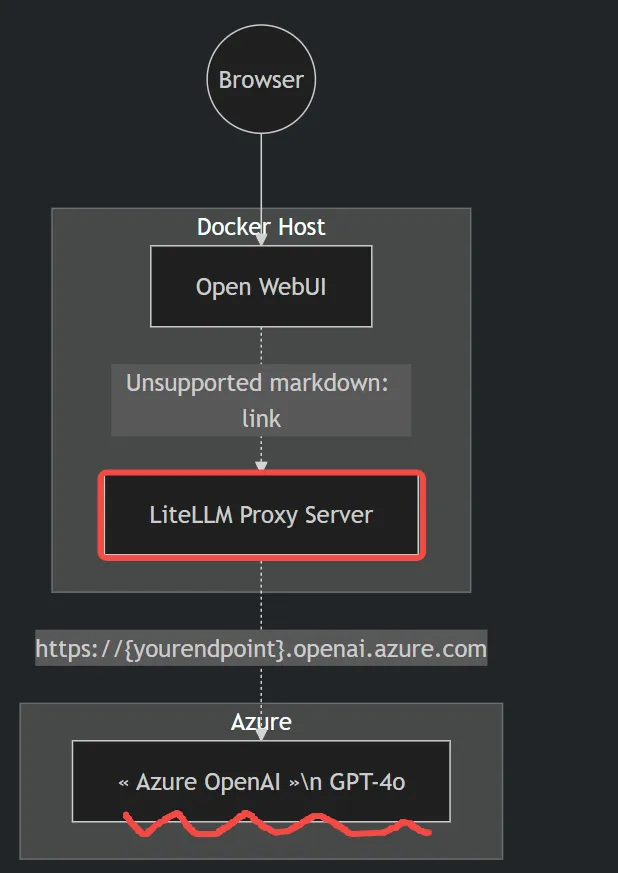

https://uright.ca/blogs/2024-07-29-unlocking-the-power-of-azure-openai-on-open-webui/

使用 litellm 简化 Azure GPT-4 调用

litellm 是一个统一接口库,它可以将 Azure 和 OpenAI 的接口规范统一,方便开发者使用。下面是如何通过 litellm 进行简单的 Azure GPT-4 调用。

Python 示例:直接调用 Azure GPT-4

python展开代码import litellm

# Azure GPT-4 API 调用示例

response = litellm.completion(

model="azure/GPT-4o", # 替换为你自己的 Azure 模型名称

api_base="https://gpt4.openai.azure.com", # Azure API base URL

api_version="2023-12-01-preview", # Azure API 版本

api_key="26e616018d3a624", # 你的 Azure API Key

messages=[{"role": "user", "content": "good morning"}], # 用户消息

)

print(response)

这个代码能够直接检查 Azure 是否通畅。请注意,litellm 库帮助统一了 Azure 和 OpenAI 接口的调用方式,简化了不同接口的使用。

使用 litellm Proxy 配置 Azure API

你可以通过 litellm 提供的 Proxy 来更便捷地管理多个接口配置。首先,创建一个 YAML 配置文件:

yaml展开代码model_list:

- model_name: 'GPT-4o' # 模型名称,随便写的

litellm_params:

model: 'azure/GPT-4o' # 必须以 azure/ 开头

api_base: 'https://gpt4.openai.azure.com/' # Azure API 基础 URL

api_version: '2023-12-01-preview' # 选择正确的 API 版本

api_key: '26e616018d3a624' # 你的 Azure API Key

安装 litellm Proxy

在命令行中安装 litellm Proxy:

bash展开代码pip install 'litellm[proxy]'

启动接口服务

使用以下命令启动本地接口服务:

bash展开代码litellm --host 0.0.0.0 --port 8000 -c litellm_config.yaml

litellm --host 0.0.0.0 --port 8000 -c litellm_config.yaml --add_key "nsyabB134.."

测试接口是否可用

你可以通过 curl 命令来测试接口是否通畅:

bash展开代码curl --location 'http://0.0.0.0:8000/chat/completions' \

--header 'Content-Type: application/json' \

--data '{

"model": "GPT-4o",

"messages": [

{"role": "user", "content": "你好,你是谁?"}

]

}'

bash展开代码curl --location 'http://0.0.0.0:8000/chat/completions' \

--header 'Content-Type: application/json' \

--header 'Authorization: Bearer nsyabB134..' \

--data '{

"model": "GPT-4o",

"messages": [

{"role": "user", "content": "你好,你是谁?"}

]

}'

总结

litellm 简化了 Azure API 调用,并且通过 Proxy 配置使得不同接口统一在 OpenAI 的规范下工作,极大地方便了开发者的使用。希望这篇教程能帮助你快速配置和测试 Azure 的 GPT-4 接口。

如果对你有用的话,可以打赏哦

打赏

本文作者:Dong

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 CC BY-NC。本作品采用《知识共享署名-非商业性使用 4.0 国际许可协议》进行许可。您可以在非商业用途下自由转载和修改,但必须注明出处并提供原作者链接。 许可协议。转载请注明出处!

目录