测试NanoFlow:比 vLLM 和 TensorRT-LLM 更快

NanoFlow项目地址: https://arxiv.org/abs/2408.12757

有个讨论,Qwen2.5和Llama 3.1 70b,用 NanoFlow 部署一下Llama 3.1 70b看看。

https://huggingface.co/Qwen/Qwen2.5-72B-Instruct/discussions/1

| 模型 | 得分 | 备注 |

|---|---|---|

| Qwen2 72b | 73.9 | 表现优于部分小型模型,但仍低于Llama 3.1 70b |

| Llama 3.1 70b | 77.9 | 最高分,表现良好 |

| Llama 3.1 8b | 62-64 | 较低得分 |

| Gemma 2 9b | 62-64 | 较低得分 |

| Qwen2.5 72b | ~50 | 与Qwen2 7b相似,知识水平显著下降 |

| Qwen2 7b | ~50 | 知识水平显著下降 |

| Gemma 2 2b | 50+ | 在流行知识上表现更好 |

NanoFlow拉镜像:

bash展开代码mkdir -p framework-test

docker run --gpus all --net=host --privileged -v /dev/shm:/dev/shm --name nanoflow -v ./framework-test:/code -it nvcr.io/nvidia/nvhpc:23.11-devel-cuda_multi-ubuntu22.04

NanoFlow拉代码和环境:

bash展开代码git clone https://github.com/efeslab/Nanoflow.git

cd Nanoflow

chmod +x ./installAnaconda.sh

./installAnaconda.sh

# restart the terminal

cd /root/anaconda3

./bin/conda init

. ~/.bashrc

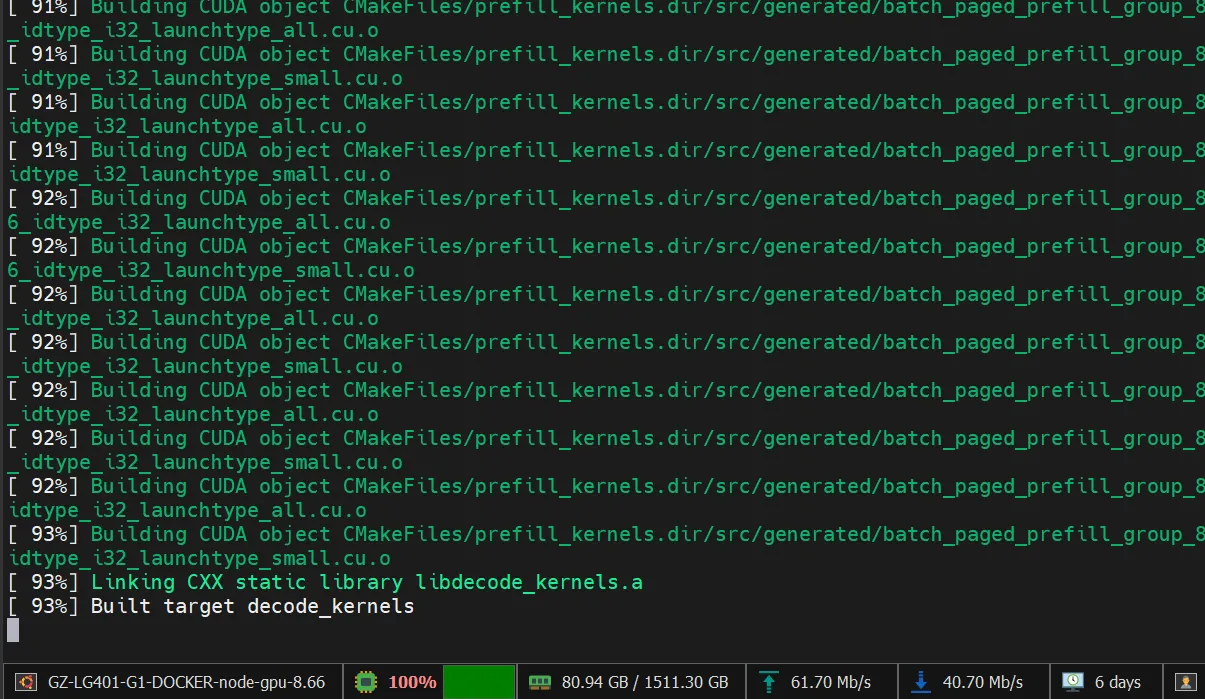

NanoFlow运行这个:

bash展开代码./setup.sh

编译很搞事情,CPU占满:

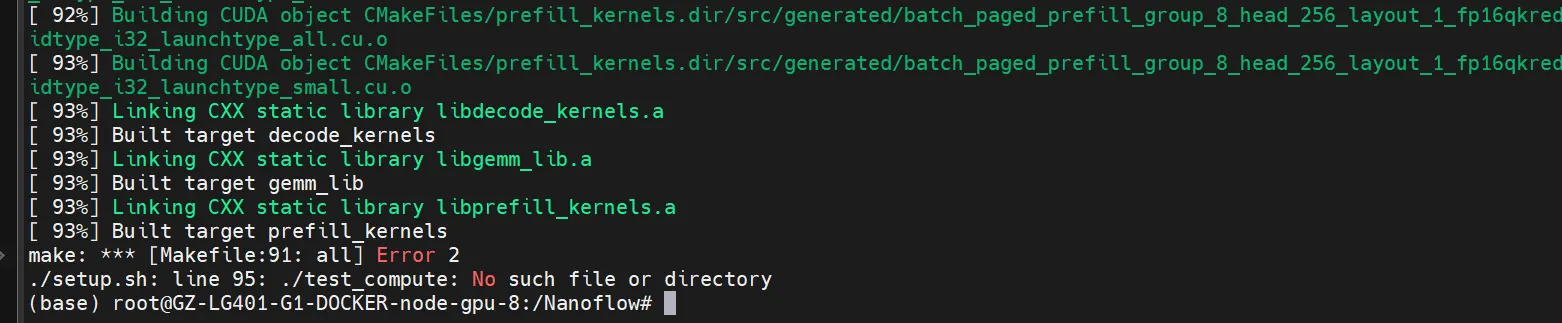

测试失败:

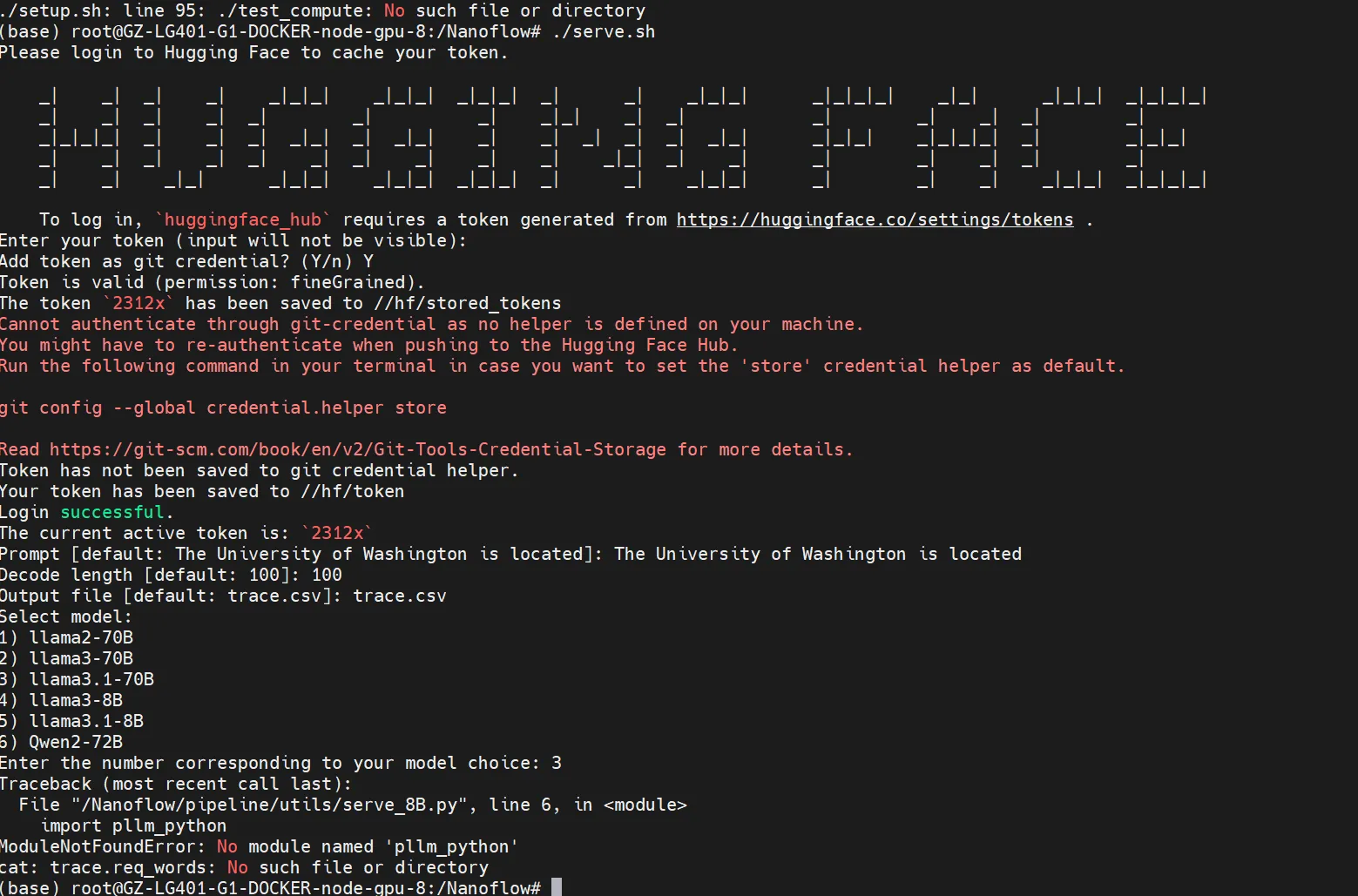

玩不了一点啊:

如果对你有用的话,可以打赏哦

打赏

本文作者:Dong

本文链接:

版权声明:本博客所有文章除特别声明外,均采用 CC BY-NC。本作品采用《知识共享署名-非商业性使用 4.0 国际许可协议》进行许可。您可以在非商业用途下自由转载和修改,但必须注明出处并提供原作者链接。 许可协议。转载请注明出处!